Dans cet article je vous propose de tester l’aventure Real-time Analytics de Microsoft Fabric.

Contexte

Microsoft Fabric propose différentes perspectives de gestion de la donnée. Nous allons ici nous concentrer sur la partie temps réel.

Pour cela je vous propose le scénario suivant, nous avons des capteurs qui émettent des données régulièrement, mais pas de manière régulière. Nous voulons pouvoir créer un rapport Power BI pour observer les données en temps réel.

Pour réaliser cela, nous devrons :

- Simuler l’envoi des données des capteurs.

- Collecter les données.

- Traiter les données.

- Restituer les données dans Power BI.

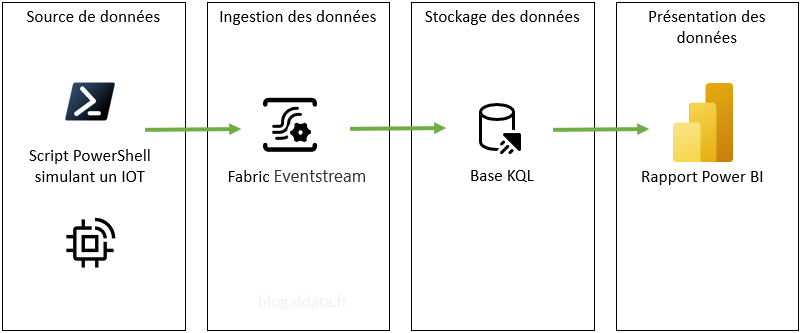

Présentation de l’architecture

Voici les différentes briques d’architecture que nous allons utiliser :

- L’envoi des données de nos capteurs sera simulé par un script PowerShell.

- La collecte des données se fera via un Eventstream de Microsoft Fabric.

- Le stockage des données sera réalisé" dans une base de données KQL.

- La restitution des données se fera dans un rapport Power BI.

Le schéma d’architecture est donc le suivant :

Présentation de nos capteurs

Pour simuler les capteurs, nous allons utiliser un simple script PowerShell qui va créer aléatoirement les messages des capteurs. Le script de création des messages des capteurs est le suivant :

|

|

Pour que cela fonctionne, ouvrez une fenêtre PowerShell, copiez le script et appuyez sur entrée pour l’exécuter.

J’ai testé avec une version de PowerShell Core 7.

Dans cette version du script, les messages sont simplement affichés dans la fenêtre PowerShell.

Préparation de l’environnement Fabric

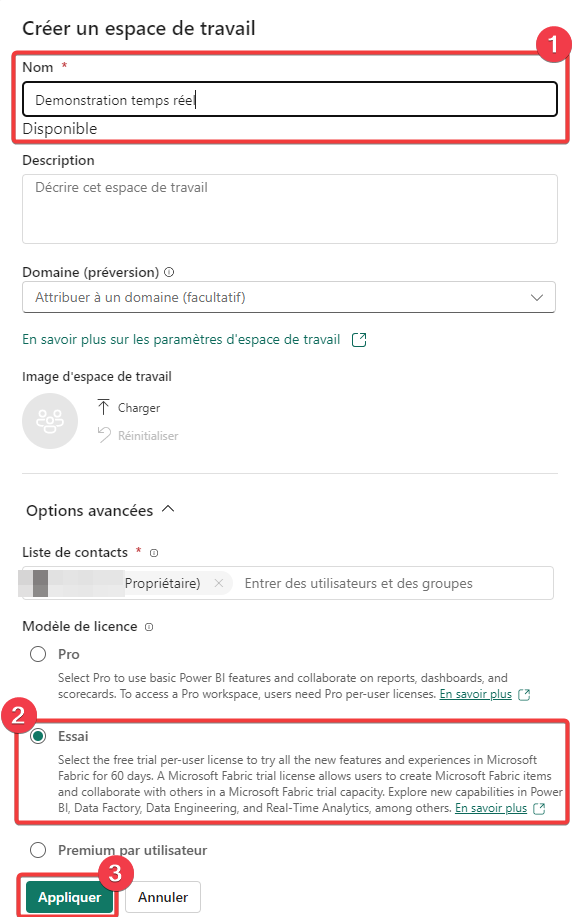

Création de l’espace de travail

Nous allons créer un nouvel espace de travail pour cette démonstration, comme cela vous pourrez le supprimer à la fin pour libérer les ressources utilisées.

Allez dans Espace de travail dans le panneau de gauche et sélectionnez + Nouvel espace de travail.

- Choisissez un nom pour votre espace de travail.

- Choisissez un modèle de licence supportant les objets Fabric.

- Appuyez sur Appliquer pour créer votre espace de travail.

Une fois l’espace de travail créer un rendez-vous dedans.

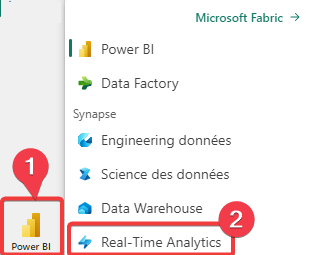

- Dans le panneau de gauche cliquez sur l’icône des expériences Fabric, tout en bas, c’est Power BI si vous êtes entré par le portail Power BI.

- Sélectionnez l’expérience Fabric Real-Time Analytics.

Réouvrez l’espace de travail si vous vous retrouvez sur l’écran d’accueil.

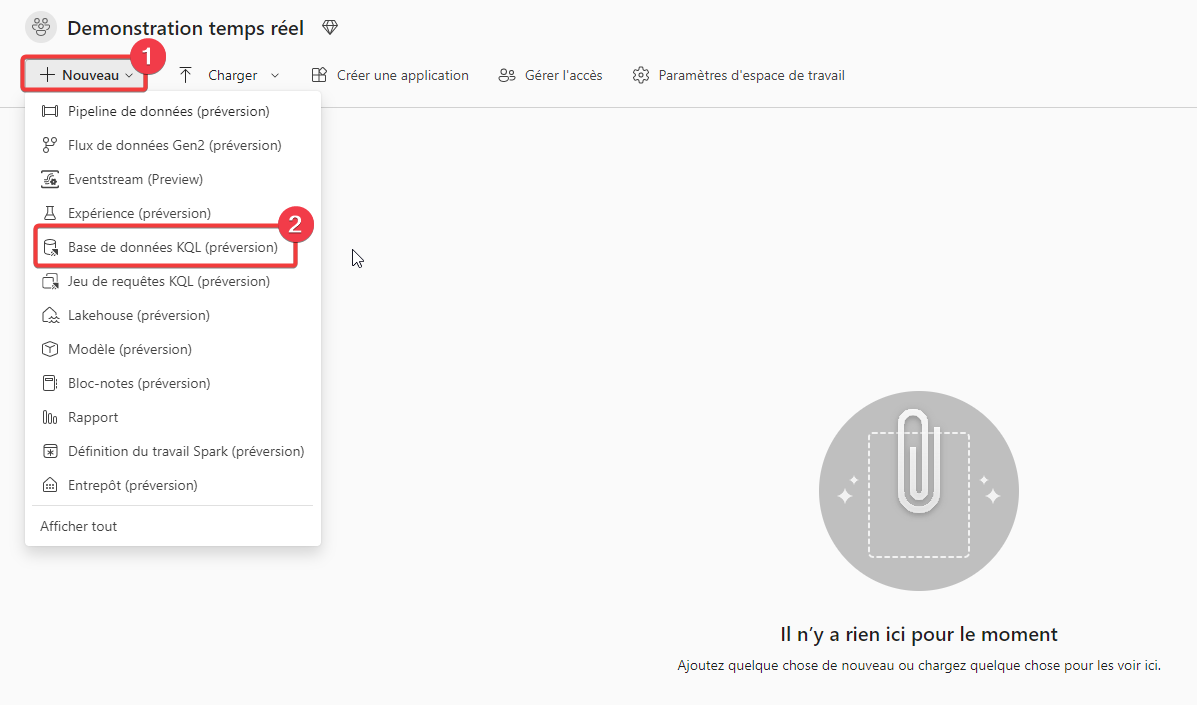

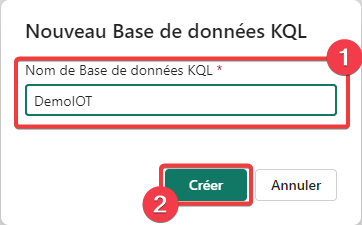

Création de la base KQL

Nous allons maintenant procéder à la création de la base de données KQL

- Appuyez sur Nouveau

- Sélectionnez Base de données KQL.

- Donnez le nom DemoIOT à la base de données.

- Appuyez sur Créer pour créer la base.

Le traitement de création peut prendre quelques secondes.

Collecte et traitement des données

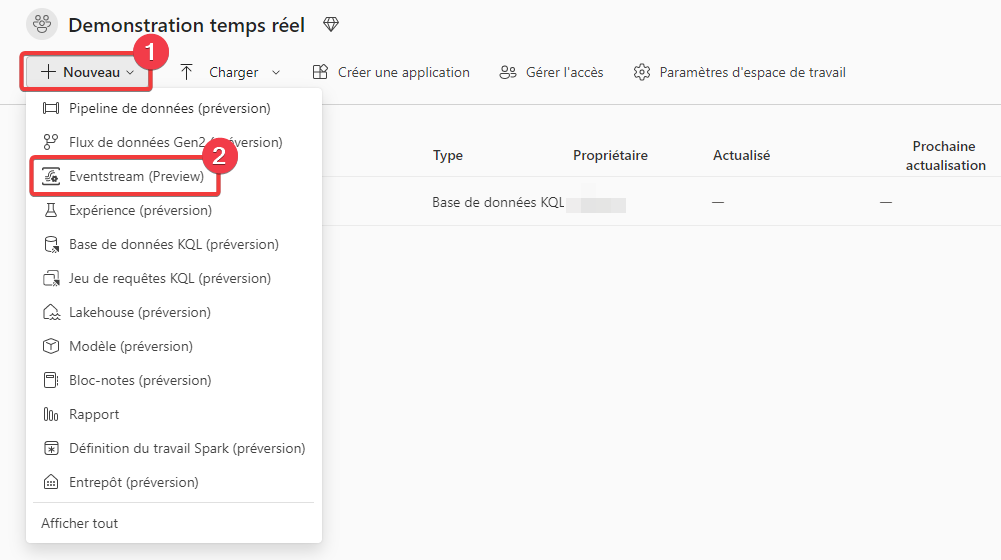

Création du traitement

Nous allons maintenant procéder à la création d’un traitement d’intégration eventstream.

- Appuyez sur Nouveau

- Sélectionnez Eventstream.

- Donnez le nom DemoIOT à l’eventstream'.

- Appuyez sur Créer pour créer l’eventstream'.

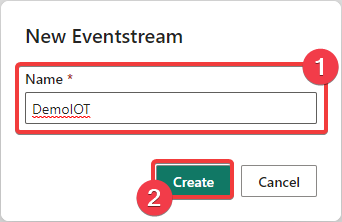

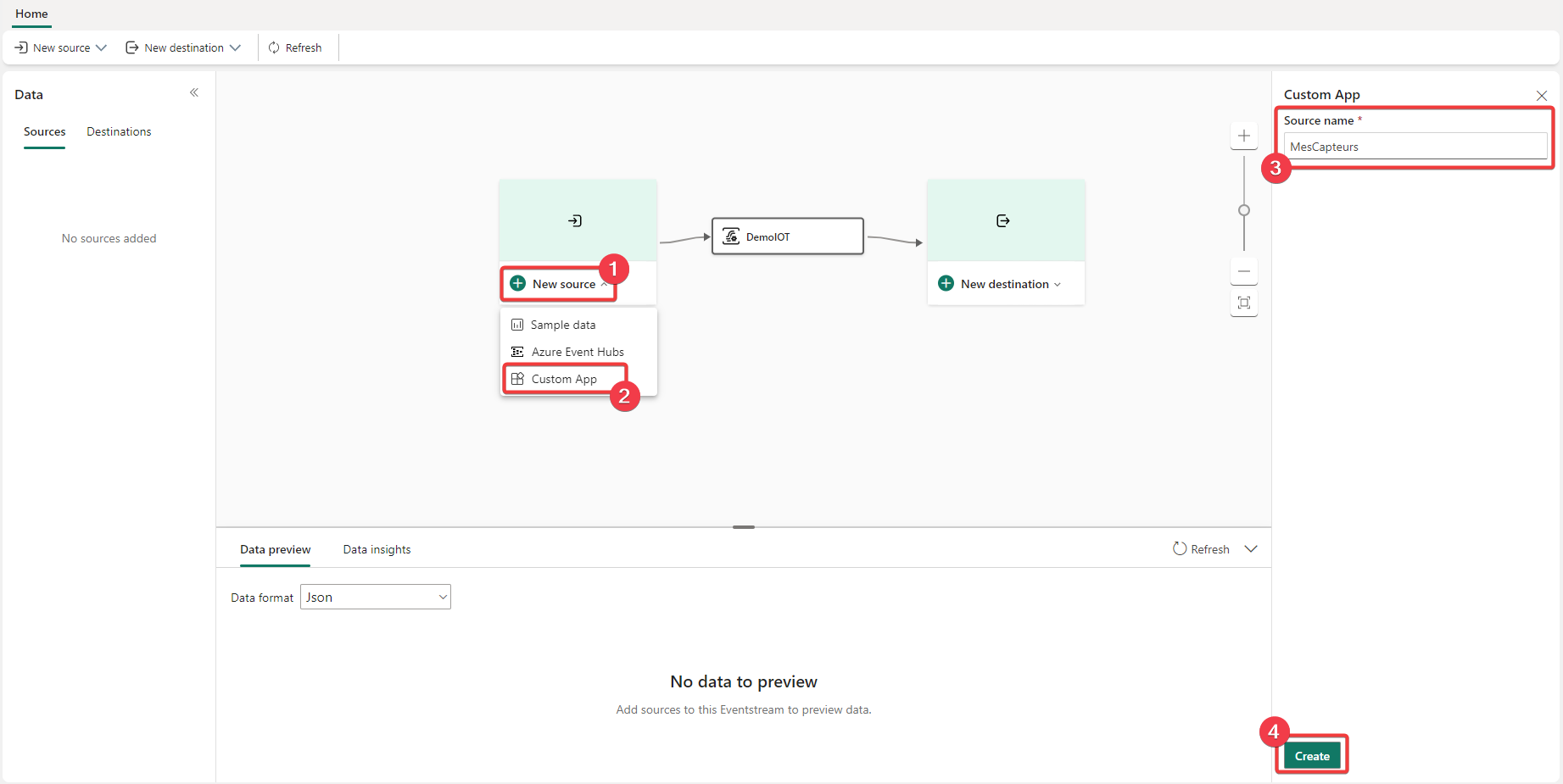

La fenêtre d’édition du traitement apparait, nous allons créer un point d’écoute pour nos capteurs en créant une Custom App dans la source du traitement.

Le point d’écoute est supporté par le service bus Azure.

- Appuyez sur New source.

- Sélectionnez Custom App.

- Donnez le nom MesCapteurs à la custom app.

- Appuyez sur Create pour créer la custom app.

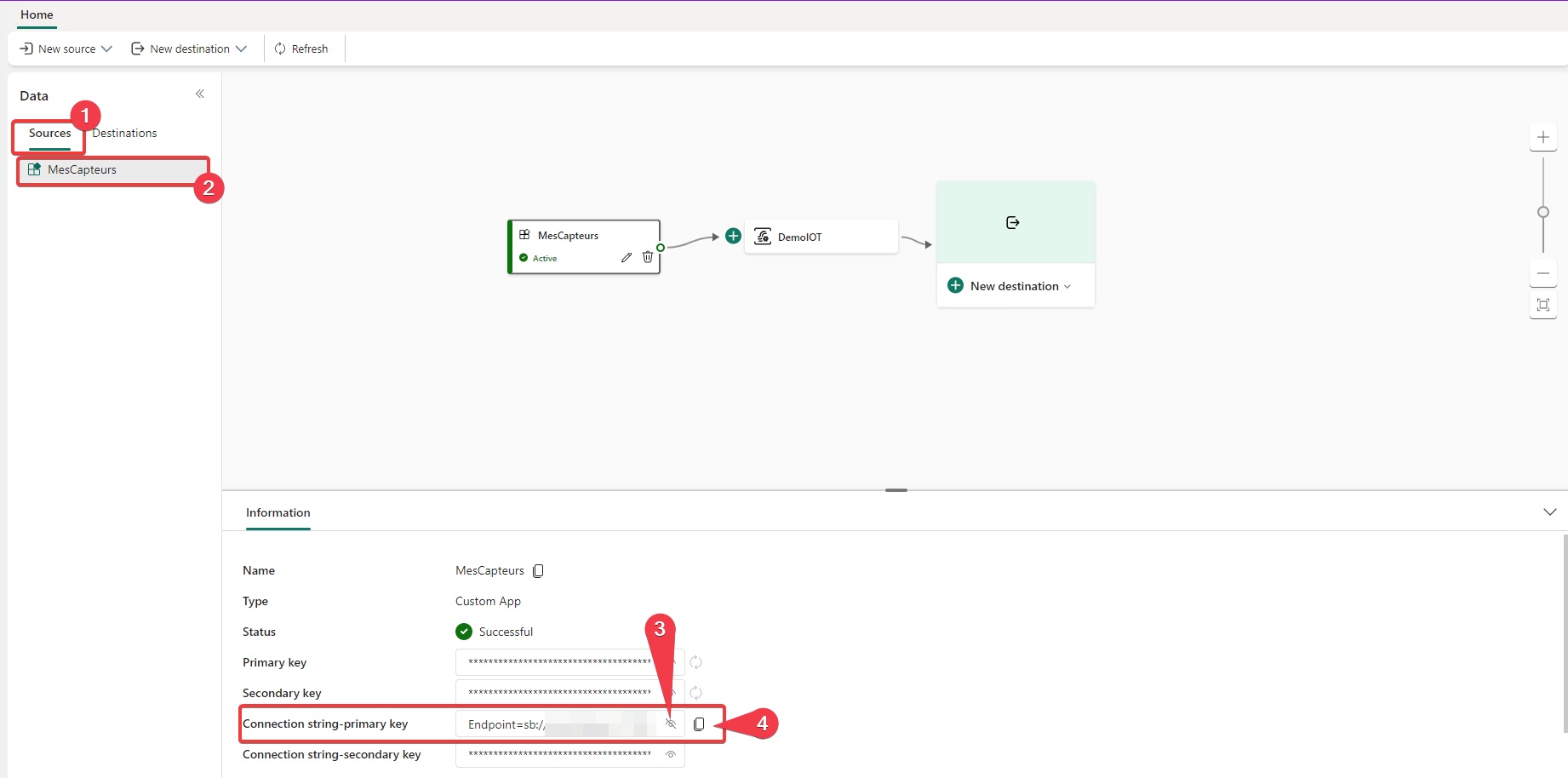

Nous allons maintenant copier la chaine de connexion au point d’écoute pour paramétrer nos capteurs.

- Vérifiez que vous êtes sur les sources de données.

- Sélectionnez la source MesCapteurs.

- Appuyez sur l’icône d’œil sir la ligne Connection string-primary key pour afficher la chaine de connexion.

- Appuyez sur l’icône de copie pour copier la chaine de connexion.

Script de simulation de capteur émettant vers notre traitement

Nous allons maintenant finaliser notre script simulant nos capteurs en ajoutant l’écriture dans le Azure service bus servant de point d"écoute.

Pour cela, remplacez la chaine de caractère REMPLACER_PAR_VOTRE_CHAINE_DE_CONNEXION par la chaine de connexion copiée à l’étape précédente sur la ligne 2 du script ci-dessous.

Le script PowerShell est inspiré de l’article Azure Service Bus with PowerShell.

|

|

Finalisation du traitement des données

Nous allons maintenant finaliser le traitement de données des capteurs en indiquant une destination aux données reçues.

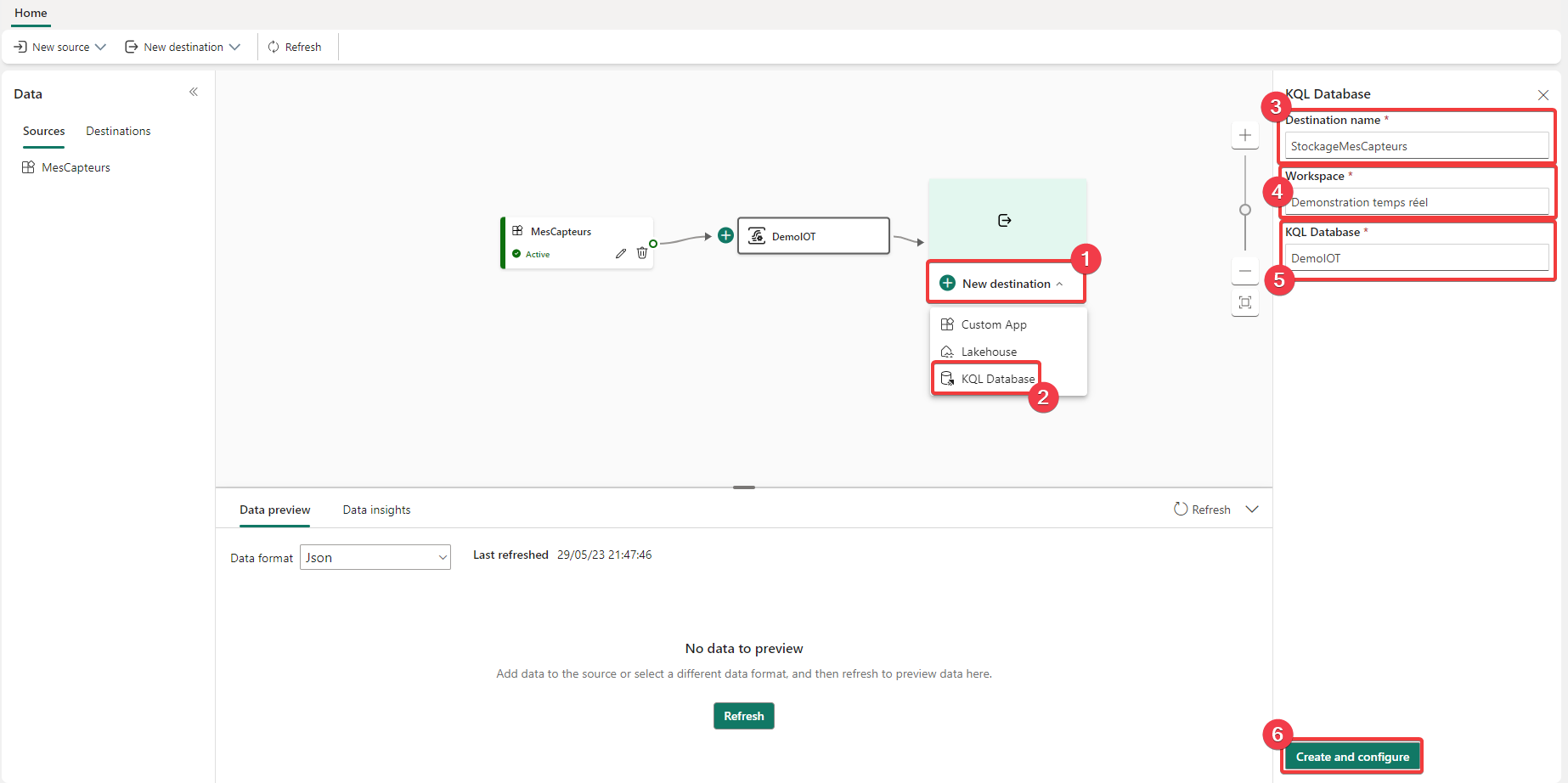

- Appuyez sur New destination.

- Sélectionnez KQL Database.

- Donnez le nom StockageMesCapteurs dans Destination name.

- Sélectionnez l’espace de travail.

- Sélectionnez la base de données KQL.

- Appuyez sur Create and configure pour continuer.

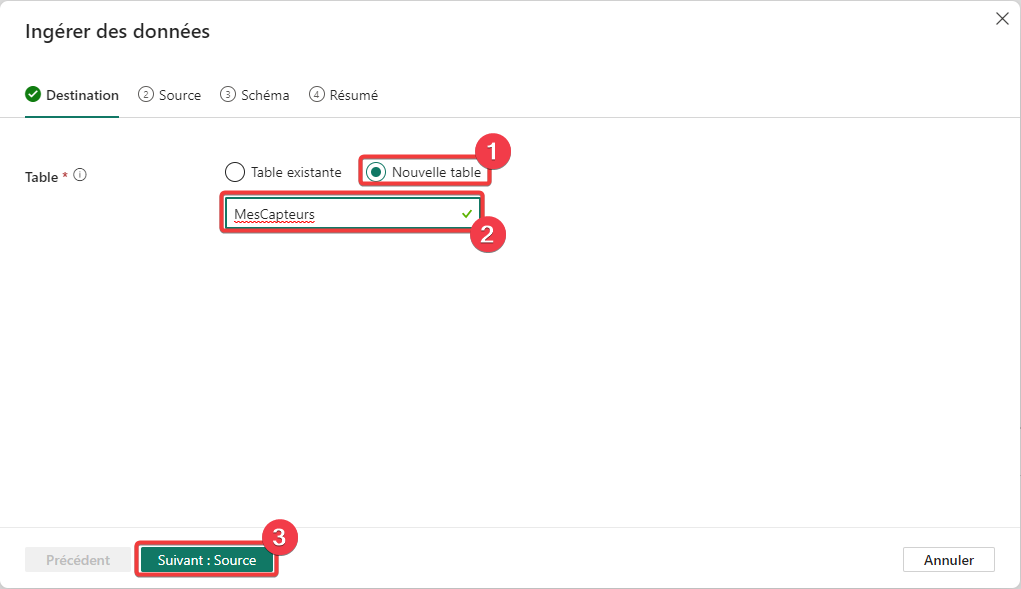

On paramètre la table de destination dans la base KQL :

- Sélectionnez Nouvelle table.

- Donnez le nom MesCapteurs à la table.

- Appuyez sur Suivant : Source pour continuer.

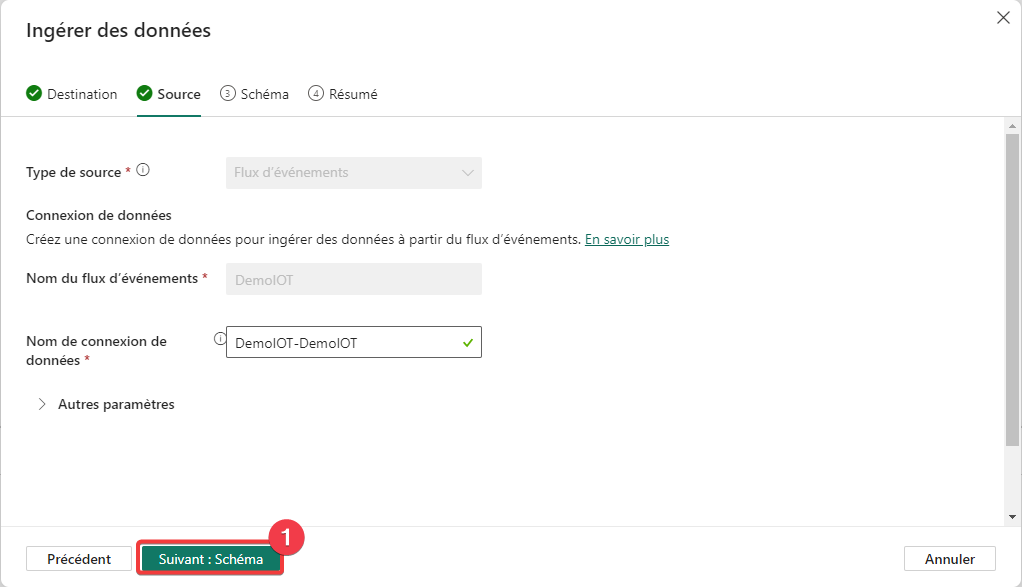

Lancez le script PowerShell paramétré avec votre chaine de connexion pour qu’il commence à émettre des données.

- Sur l’écran Source laissez les paramètres par défaut et appuyez sur Suivant : Schéma pour continuer.

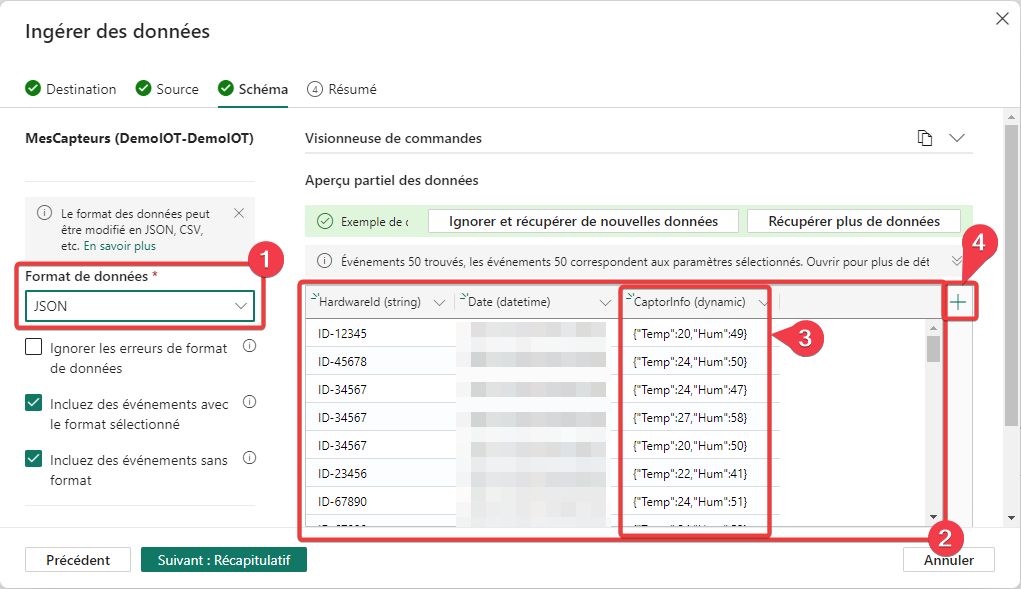

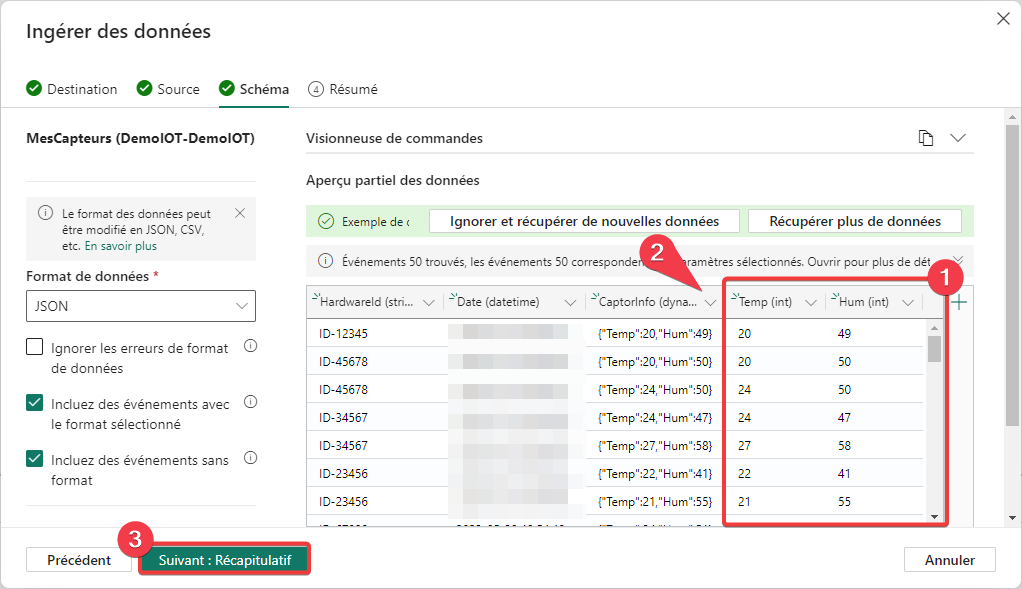

- Choisissez le format de données JSON.

- Vous pouvez voir que des données arrivent de vos capteurs.

- Les données de la colonne CaptorInfo sont au format JSON, pour une analyse plus simple nous allons réaliser une transformation de données consistant à créer une colonne par valeur.

- Cliquez sur le symbole + pour ajouter une colonne.

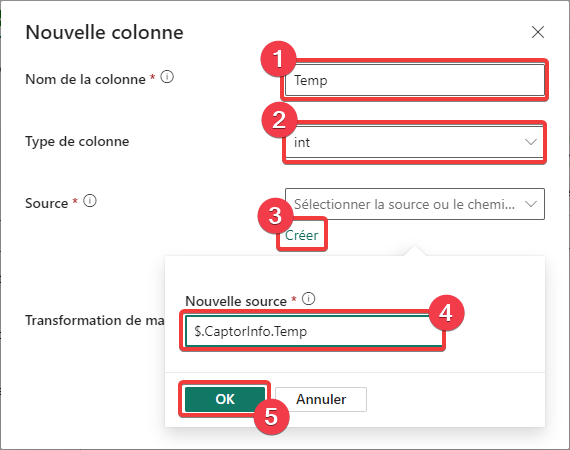

- Saisissez Temp dans le nom de la colonne.

- Appuyez sur Créer pour saisir le chemin de la source de données.

- Choisir Int dans Type de colonne.

- Entrez $.CaptorInfo.Temp dans Nouvelle source. Le symbole $ représente la racine du document JSON, nous indiquons ensuite le nom des clés amenant à la valeur qui nous intéresse.

- Appuyez sur OK pour ajouter la colonne.

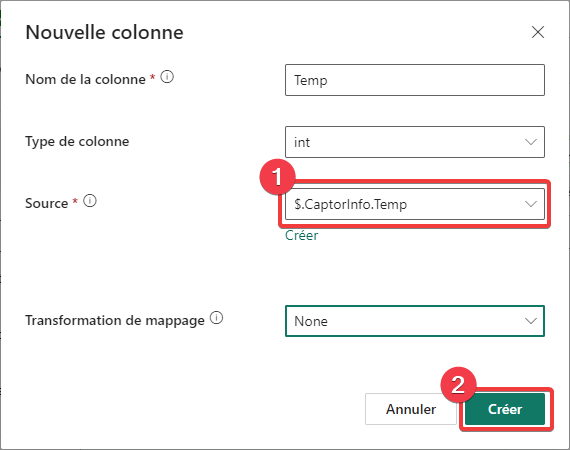

- Vous pouvez voir la valeur saisie pour la nouvelle colonie.

- Appuyez sur Créer pour ajouter la colonne.

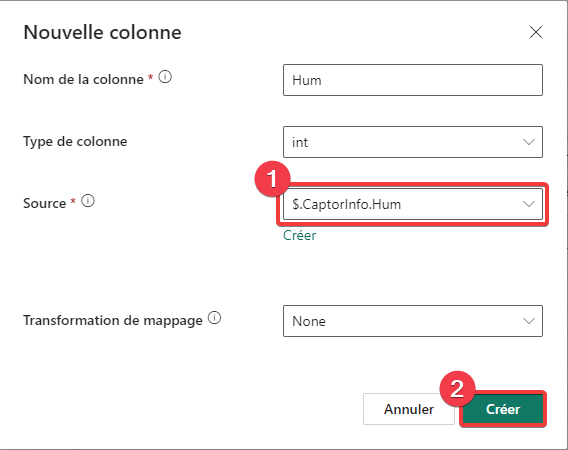

- Répétez l’opération pour la colonne Hum, entrez $.CaptorInfo.Hum dans Nouvelle source.

- Appuyez sur Créer pour ajouter la colonne.

- Vous pouvez maintenant voir vos 2 nouvelles colonnes.

- Vous pouvez supprimer la colonne CaptorInfo. Appuyez sur le chevron vers le bas et sélectionnez Delete column.

- Appuyez sur Suivant : Récapitulatif pour continuer.

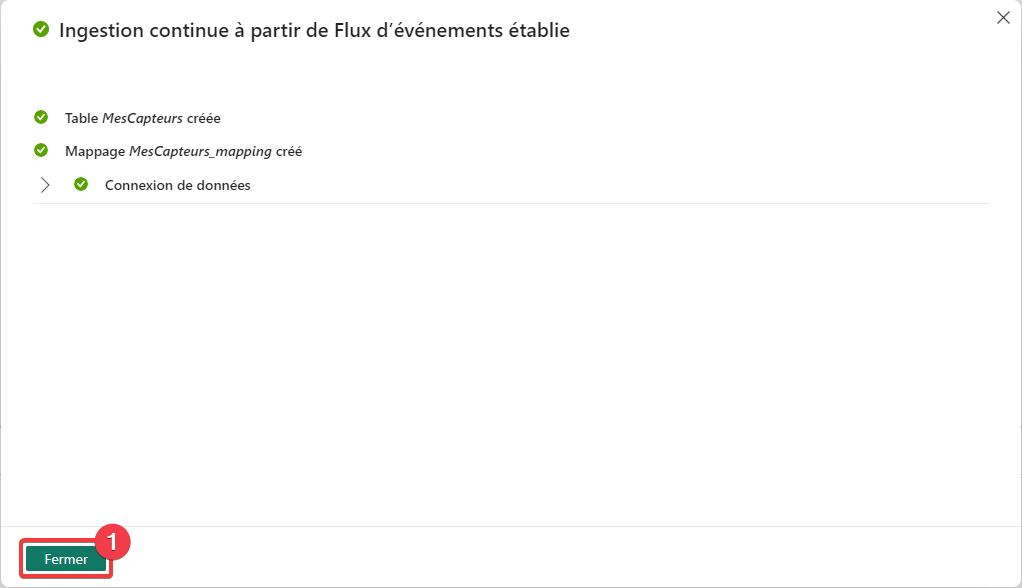

- Vous avez fini de configurer la destination, appuyer sur Fermer.

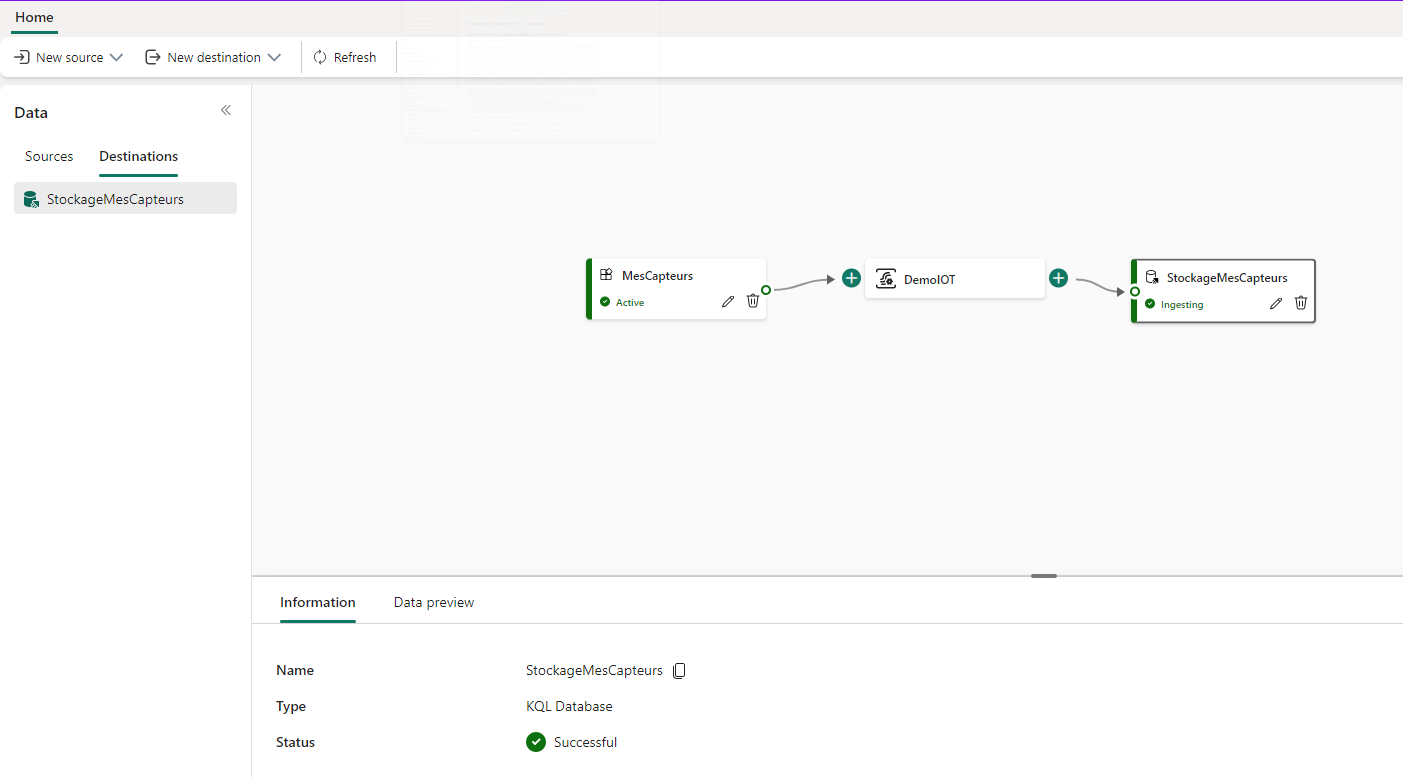

Votre traitement d’intégration ressemble à cela :

Restitution des données

Pour la restitution des données, nous allons utiliser les assistants disponibles au niveau de la base de données KQL.

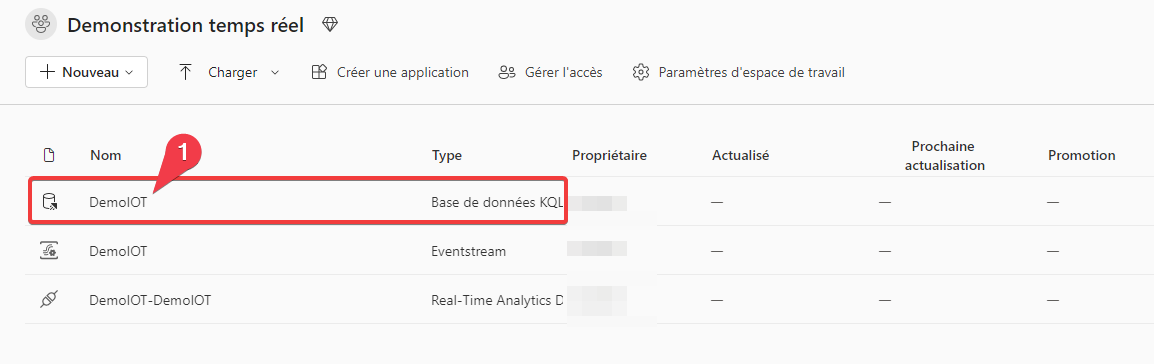

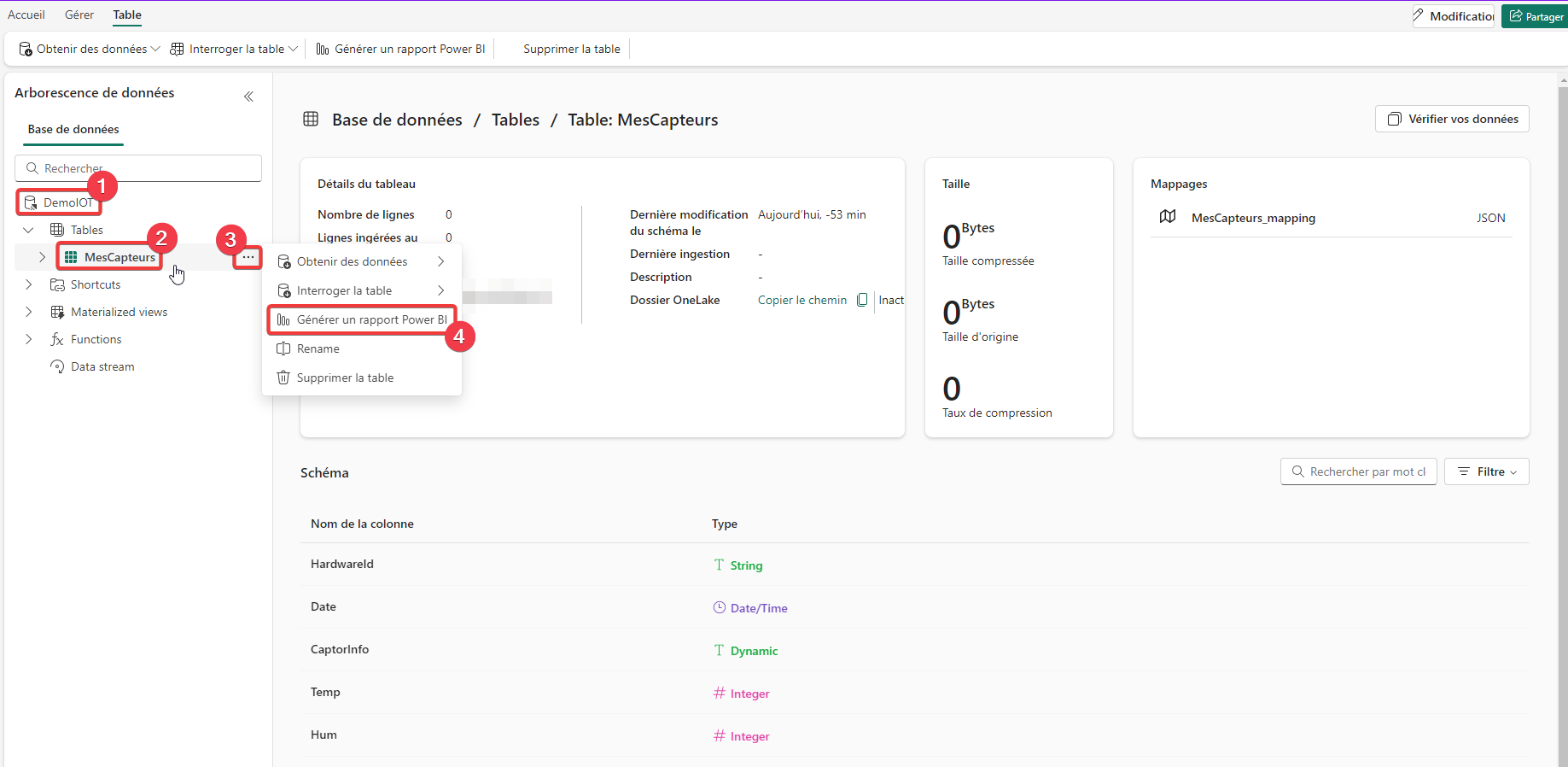

- Rendez-vous dans votre espace de travail est cliqué sur la base de données KQL.

Création du rapport Power BI

- Vous pouvez voir la base de données KQL que l’on a créée.

- Appuyez sur la table MesCapteurs pour la sélectionner.

- Appuyer sur les 3 points au niveau du nom de la table pour ouvrir le menu contextuel.

- Sélectionnez Générer un rapport Power BI.

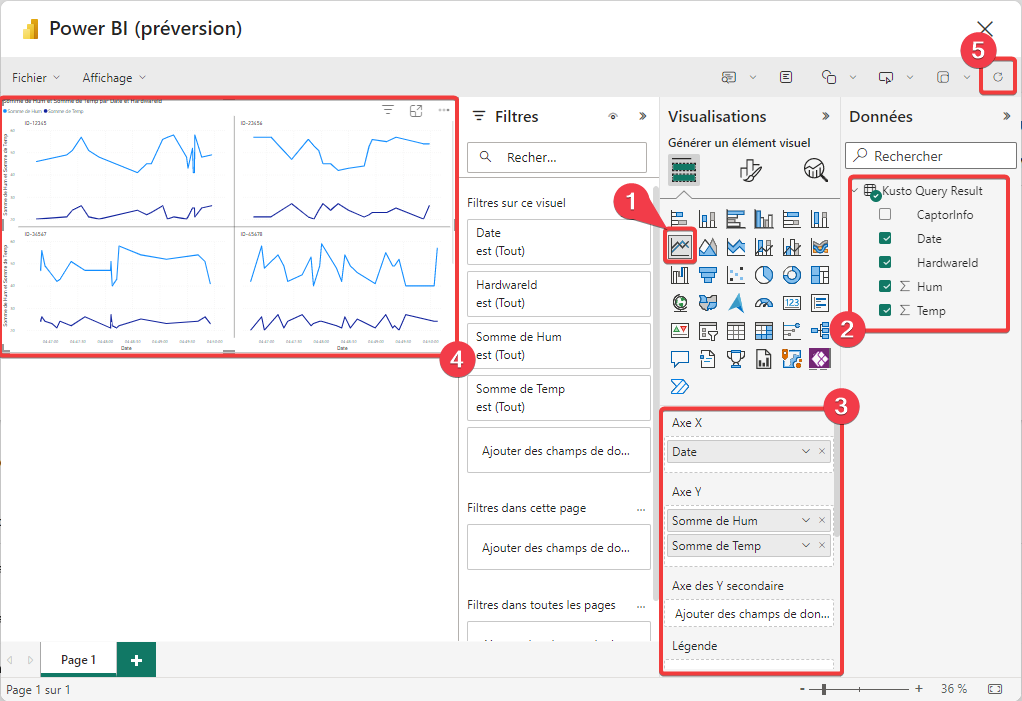

L’extraction des données via une requête KQL est faite automatiquement par l’assistant. Une fenêtre de création de rapport Power BI apparait. Le jeu de données associé à ce rapport correspond aux données de notre table.

- Ajouter un visuel Graphique en courbe dans votre rapport et positionnez-le pour recouvrir la zone de dessin.

- Dans Données vous retrouvez les champs de votre table extraits par une requête KQL.

- Positionez les champs sur le graphique :

- Mettre Date dans Axe X.

- Mettre Hum et Temp dans Axe Y.

- Mettre HardwareId dans Petits multiples.

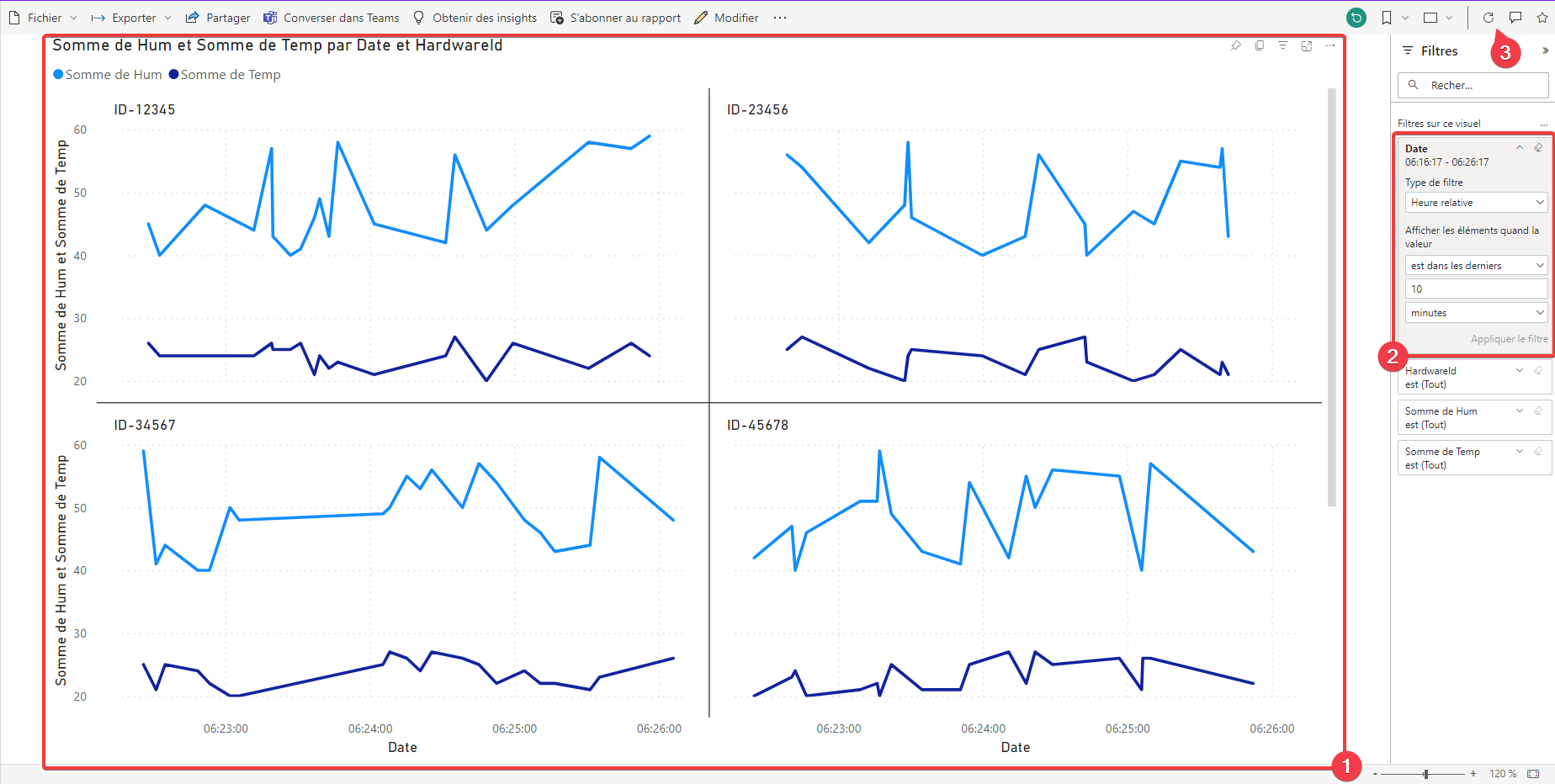

- Votre graphe doit ressembler à cela.

- Si aucune donnée n’est présente, relancer le script PowerShell et appuyer sur le bouton Actualiser du rapport.

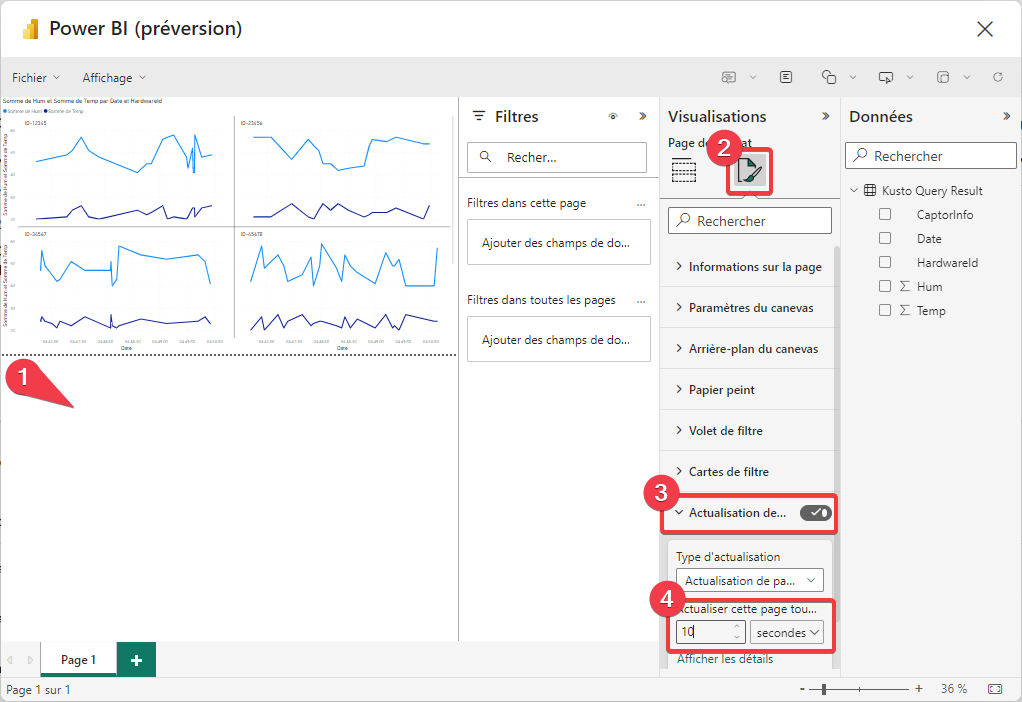

- Cliquez dans la zone sous les pointillés pour accéder aux paramétrages de la page du rapport Power BI.

- Rendez-vous dans l’onglet de mise en forme.

- Activez Actualisation de la page en basculant le bouton et cliquez sur le texte pour ouvrir le panneau de configuration.

- Paramétrez votre page pour une actualisation automatique toutes les 10 secondes.

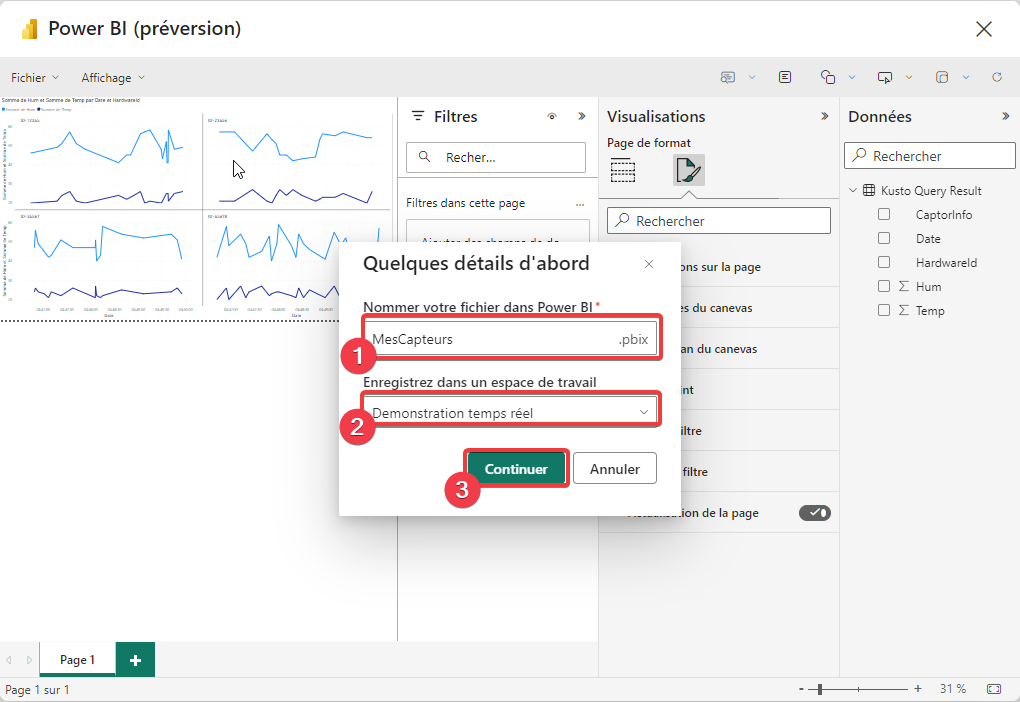

Dans le menu fichier, appuyez sur Enregistrer.

- Donnez un nom à votre rapport.

- Sélectionnez l’espace de travail.

- Appuyez sur Continuer pour publier le rapport.

Vous pouvez maintenant fermer la fenêtre Power BI.

Test du rapport Power BIPower BI

Retournez dans l’espace de travail où vous avez sauvegardé le rapport Power BI et ouvrez-le.

- Vous pouvez voir ici vos données qui vont se rafraichir automatiquement si le script PowerShell s’exécute.

- Vous pouvez ajouter un filtre sur les 10 dernières minutes de données pour ne pas voir les données des tests précédents.

- Si le rafraichissement ne se fait pas vous pouvez le forcer via le bouton Actualiser.

Lors de mes expérimentations, le rafraichissement automatique du rapport Power BI était plutôt chaotique. Le rafraichissement par le bouton Actualiser rafraichissait bien les données donc c’est la partie Power BI qui ne se comporte pas tout à fait comme attendu.

Conclusion

Dans ce scénario je simule des capteurs d’IOT, mais vous pouvez utiliser cette technique pour n’importe quel type de données. Par exemple vous pouvez monitorer vos scripts PowerShell en envoyant directement des données à la base KQL.

Merci de votre attention.